前言

本篇继续学习webgl的内容

多个点绘制不同的颜色

步骤

1.在顶点着色器中,建立一个名为a_Color 的attribute 变量,并通过varying 变量将其全局化,之后可以在片着色器中拿到。

1 | <script id="vertexShader" type="x-shader/x-vertex"> |

2.在片元着色器中获取顶点着色器中全局化的varying 变量,然后将其作为片元颜色。

1 | <script id="fragmentShader" type="x-shader/x-fragment"> |

3.在js中,将顶点数据批量传递给顶点着色器。

1 | //顶点数据 |

4.用同样原理将颜色数据批量传递给顶点着色器。

1 | //颜色数据 |

5.绘制顶点

1 | //刷底色 |

完整代码

1 |

|

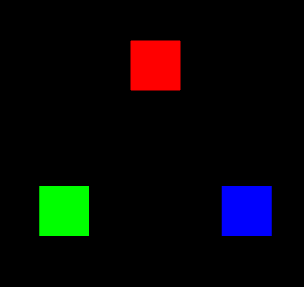

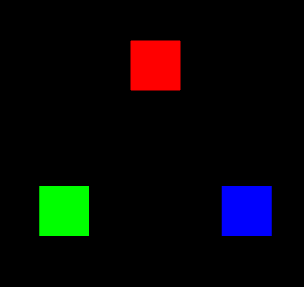

效果

多attribute数据合一

概念

在上面的代码中,我们写了一个顶点数据,又写了一个颜色数据,感觉非常的鸡肋,其实我们可以把这个attribute给合并起来。

1 | const source = new Float32Array([ |

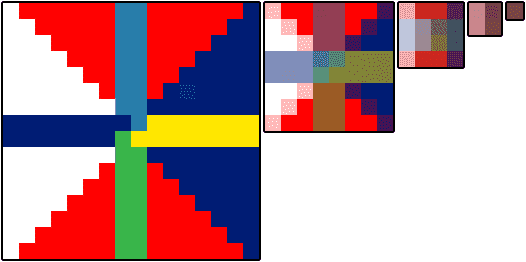

我们可以看到,左半边是我们的position,右边是color。

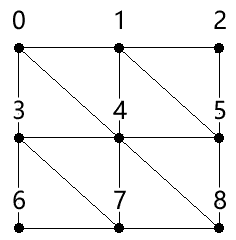

对应上面的数据,我们要先有以下概念:

- 数据源:整个合而为一的数据source

- 元素字节数:32位浮点集合中每个元素的字节数

- 类目:一个顶点对应一个类目,也就是上面source中的每一行

- 系列:一个类目中所包含的每一种数据,比如顶点位置数据、顶点颜色数据

- 系列尺寸:一个系列所对应的向量的分量数目

- 类目尺寸:一个类目中所有系列尺寸的总和

- 类目字节数:一个类目的所有字节数量

- 系列元素索引位置:一个系列在一个类目中,以集合元素为单位的索引位置

- 系列字节索引位置:一个系列在一个类目中,以字节为单位的索引位置

- 顶点总数:数据源中的顶点总数

1 | //数据源 |

代码

1 |

|

void gl.vertexAttribPointer(index, size, type, normalized, stride, offset)

- index:attribute 变量,具体而言是指向存储attribute 变量的空间的指针

- size:系列尺寸

- type:元素的数据类型

- normalized:是否归一化

- stride:类目字节数

- offset:系列索引位置

效果

绘制彩色三角形

我们直接用上面的三个颜色的顶点来绘制三角形

1 | //绘制顶点 |

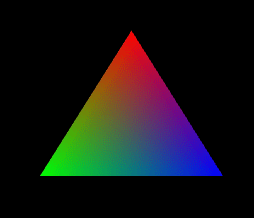

此时的三角形是这样的

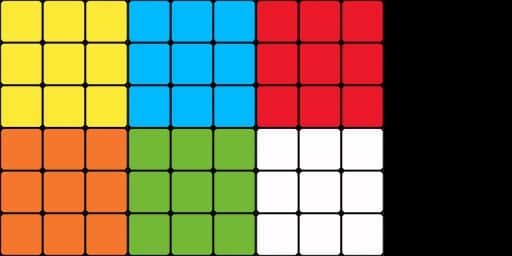

为什么会画出一个具有三种颜色的三角形呢?

这是因为我给三角形的三个顶点绑定了三种颜色。

那为什么这三种颜色可以平滑过渡呢?这其中的规律是什么?

我们通过下面这个图便可以很好的去理解,它就是在三个点之间做线性补间,将补间得出的颜色填充到三角形所围成的每个片元之中。

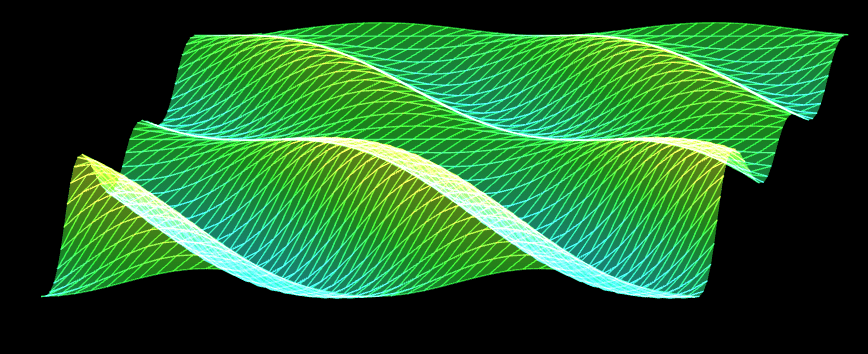

一抹绿意

上一篇文章中,我们用sin函数实现了一个一池春水案例,接下来,我们将这个案例继续美化一下

修改Poly

首先我们根据上面的知识,重新写一个Poly.js出来

定义Poly的基本属性

1 | const defAttr = () => ({ |

- source 数据源

- sourceSize 顶点数量,数据源尺寸

- elementBytes 元素字节数

- categorySize 类目尺寸

- attributes attribute属性集合,其数据结构如下:

1

2

3

4

5

6

7

8

9{

a_Position: {

size: 3,

index:0

}

}

// a_Position 对应attribute变量名

// size 系列尺寸

// index 系列的元素索引位置 - uniforms uniform变量集合,其数据结构如下:

1

2

3

4

5

6

7

8

9{

u_Color: {

type: 'uniform1f',

value:1

}

}

// u_Color 对应uniform变量名

// type uniform变量的修改方法

// value uniform变量的值

Poly对象的构造函数

1 | constructor(attr){ |

初始化方法

1 | init(){ |

calculateSize() 基于数据源计算类目尺寸、类目字节数、顶点总数

1 | calculateSourceSize() { |

updateAttribute() 更新attribute 变量

1 | updateAttribute() { |

updateUniform() 更新uniform变量

1 | updateUniform() { |

draw() 绘图方法

1 | draw(type = this.type) { |

完整代码

1 | /* |

实现逻辑

顶点着色器

1 | <script id="vertexShader" type="x-shader/x-vertex"> |

片元着色器

1 | <script id="fragmentShader" type="x-shader/x-fragment"> |

初始化着色器

1 | const canvas = document.getElementById('canvas'); |

建立视图矩阵

1 | /* 视图矩阵 */ |

建立在x,z方向上的比例尺,将空间坐标和弧度相映射

1 | /* x,z 方向的空间坐标极值 */ |

建立将y坐标和色相相映射的比例尺

1 | /* y 方向的坐标极值 */ |

建立颜色对象,可通过HSL获取颜色

1 | const color = new Color() |

建立波浪对象

1 | /* 波浪对象的行数和列数 */ |

getSource() 方法是基于行列数和坐标极值获取数据源的方法

1 | /* 建立顶点集合 */ |

渲染

1 | render() |

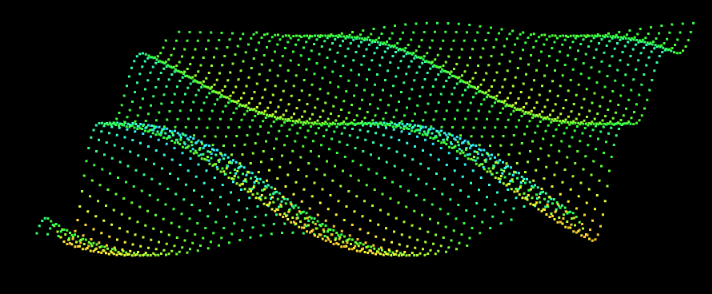

制作定点起伏动画,并添加颜色

1 | /* 动画:偏移phi */ |

此时我们将我们的点给连接了起来

一片春色

有了上面连点成线的案例,接下来要连点成面了。

回顾怎么画独立三角形

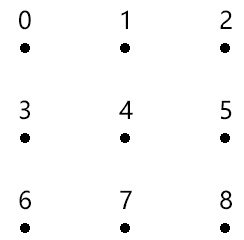

比如这样的几个点

根据画独立三角形的规则,可以划分成这样

1 | [ |

代码实现

开启透明度合成

1 | gl.enable(gl.BLEND); |

建立基于行列获取顶点索引的方法

1 | const getInd = GetIndexInGrid(cols, categorySize) |

获取顶点阵列和三角形的顶点索引集合

1 | const { vertices, indexes } = crtBaseData( |

crtBaseData() 是基于行列数和空间极值获取顶点阵列和三角形的顶点索引集合的方法。

vertices 顶点阵列

indexes 三角形的顶点索引集合

1 | function crtBaseData(cols, rows, minPosX, maxPosX, minPosZ, maxPosZ) { |

建立波浪对象

1 | const wave = new Poly({ |

getSource() 是通过顶点阵列和三角形的顶点索引集合获取数据源的方法。

1 | function getSource(vertices, indexes, categorySize) { |

渲染

1 | function render() { |

完整代码

1 |

|

效果

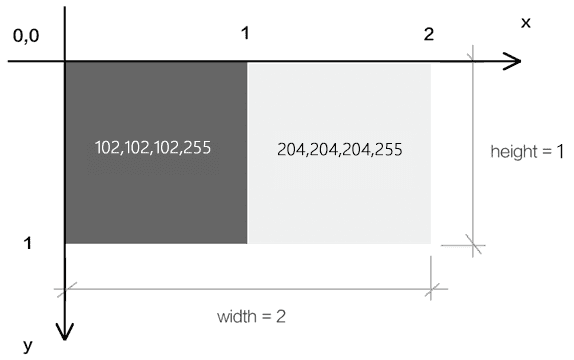

了解纹理需要的基础概念

栅格系统

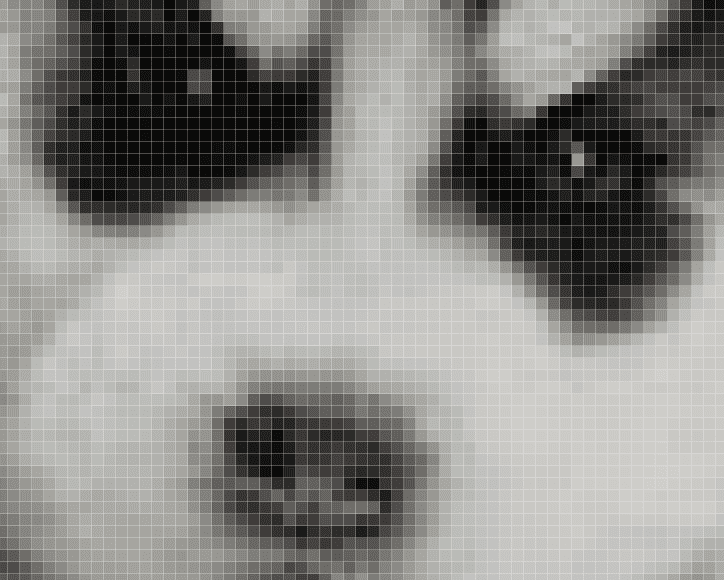

我们在说图像的时候,往往都是指点阵图、栅格图、位图(png,jpg这种)。

而与其相对应的是图形,也做矢量图(svg这种)。

我接下来说的纹理,就是属于图像,其图像的建立和显示会遵循栅格系统里的规范。

比如,所有图像都是由像素组成的,在webgl里我们把像素称为片元,像素是按照相互垂直的行列排列的。

如下图

当我们把图片在PS中放大之后,可以很明显的看到像素点

图像中的每个像素都可以通过行数y和列数x来找到,由(x,y) 构成的点位,就是图像的像素坐标。

因为canvas画布也是一张图像,所以图像的栅格坐标系和我们之前说过的canvas2d的坐标系是一样的,我们可以简单回顾一下:

栅格坐标系的原点在左上角。

栅格坐标系的y 轴方向是朝下的。

栅格坐标系的坐标基底由两个分量组成,分别是一个像素的宽和一个像素的高。

图钉概念

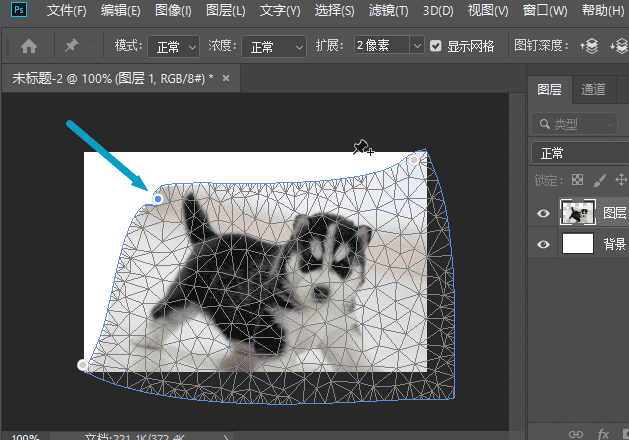

在webgl中实际上是没有图钉概念的,这个概念是为了方便我们理解webgl引入的,这里拿ps的图钉举例

在ps中,我们可以添加这样一个图钉,然后给图片进行变形

webgl中,图钉的位置是通过uv坐标来控制的,图钉的uv坐标和顶点的webgl坐标是两种不同的坐标系统,之后我们会其相互映射,从而将图像特定的一块区域贴到webgl图形中。

比如我将其映射到下面的蓝色三角形中:

注:我们在webgl里打图钉的时候不会发生边界线的扭曲,上图重在示意。

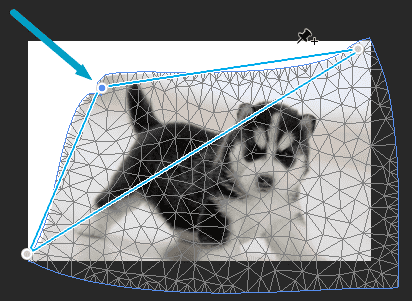

uv坐标系

我们在webgl里打图钉的时候,要考虑图钉在图像中的定位。

说到定位,大家不要先想位置,而是要先想坐标系,咱们接下来说一下图钉使用的uv坐标系。

uv坐标系,也叫st坐标系,大家以后见到了知道是一回事即可。

uv坐标系的坐标原点在图像的左下角,u轴在右,v轴在上。

u轴上的1个单位是图像的宽;

v轴上的一个单位是图像的高。

采样器

采样器是按照图钉位置从图像中获取片元的方式。

我们在图像中所打的图钉位置,并不是图像中某一个片元的位置,因为片元位置走的是栅格坐标系。

所以我们需要一个采样器去对图钉的uv坐标系和像素的栅格坐标系做映射,从而去采集图像中图钉所对应的片元。

着色器基于一张图像可以建立一个,或多个采样器,不同的采样器可以定义不同的规则去获取图像中的片元。

采样器在着色器中是一种变量类型,写做sampler2D,它就像我们之前写过的vec4 类型一样,可以在片元着色器中通过uniform变量暴露给js,让js对其进行修改。

既然js可以对采样器进行修改了,那js必然会以某种方式向着色器传递其建立采样器所需的数据。

接下来咱们就先说一下这种的数据。

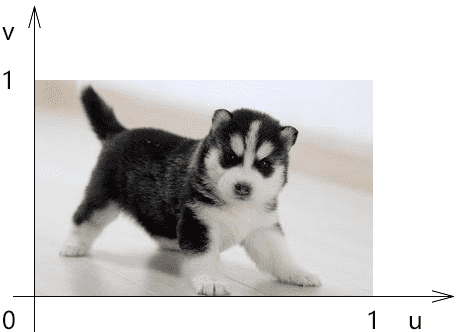

纹理对象

着色器使用一个纹理对象,就可以建立一个采样器。

纹理对象的建立需要一个图像源,比如Image 对象。

同是,我们还需要设置纹理对象和图钉进行数据映射的方式。

纹理对象是通过js 来建立的,js并不能直接将纹理对象传递给着色器。因为纹理对象说的是js 语言,说glsl es语言的着色器是不认识这种语言的。

所以,webgl 在浏览器底层为纹理对象建立了一块缓冲区,缓存区可以理解为用于存放纹理对象的磁盘空间,这块空间可以将纹理对象翻译成着色器可以读懂的数据。

之后我们会把这个空间的索引位置传给着色器,让着色器基于这个空间的索引位置,找到这个空间,然后再从空间中找到纹理对象,最后通过纹理对象建立采样器。

接下来咱们就说一下这个用于存储纹理对象的空间-纹理单元。

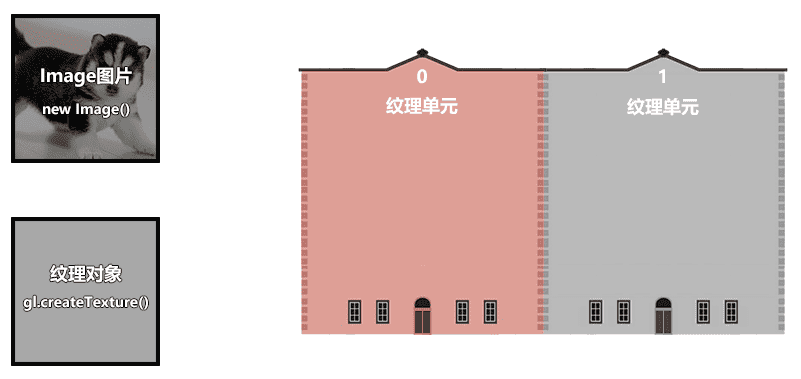

纹理单元

纹理单元是一种专门用来存放纹理对象的缓冲区,就像我们之前用createBuffer()方法建立的用于存储数据源的缓冲区一样。

纹理单元是由webgl提前建立好的,只有固定的几个,如TEXTURE0|1|2|3|4|5|6|7|8,(最好不要超过8个),这就像我们实际中住的楼房单元一样,已经被webgl提前在浏览器中建立起来了,数量有限。

纹理单元虽然无需我们自己建立,但需要我们自己激活,让其进入使用状态。

基本概念咱们就说到这,接下来咱们看一下整体的代码实现。

使用纹理的代码逻辑

顶点着色器

1 | <script id="vertexShader" type="x-shader/x-vertex"> |

a_Pin 图钉位置

片元着色器

1 | <script id="fragmentShader" type="x-shader/x-fragment"> |

sampler2D 是uniform 变量的类型,叫做二维取样器

texture2D() 基于图钉从取样器中获取片元颜色

初始化着色器

1 | const canvas = document.getElementById('canvas'); |

建立数据源,并计算相应尺寸

1 | //数据源 |

数据源中有两个系列,分别是顶点位置系列和图钉位置系列。左边俩个是顶点位置,右边俩个是图钉位置

将数据源写入到缓冲区,让attribute变量从其中寻找数据

1 | const sourceBuffer = gl.createBuffer(); |

建立Image 图像作为图像源,当图像源加载成功后再贴图

1 | //对纹理图像垂直翻转 |

贴图详解

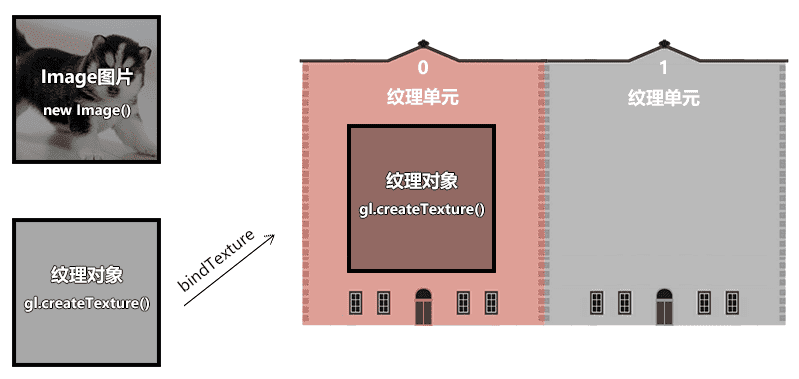

准备三个角色

Image 图像

纹理对象

纹理单元

1 | //纹理单元 |

- activeTexture(gl.TEXTURE0) 激活0号单元

- createTexture() 创建纹理对象

把纹理对象装进当前已被激活的纹理单元里

1 | const texture = gl.createTexture(); |

TEXTURE_2D 纹理对象的类型

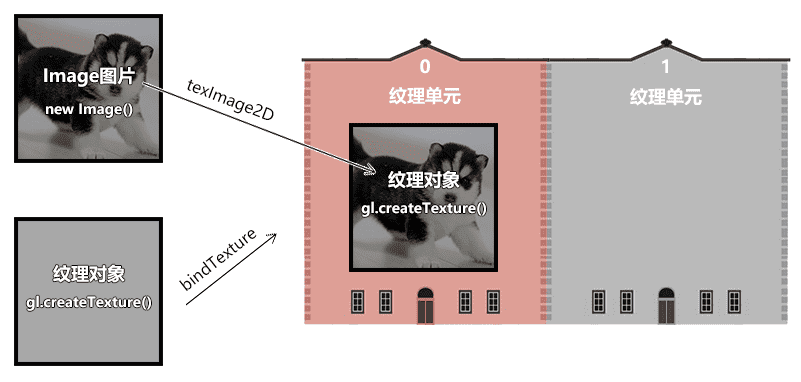

当Image 图像加载成功后,把图像装进当前纹理单元的纹理对象里

1 | gl.texImage2D( |

texImage2D(type, level, internalformat, format, type, pixels)

- type 纹理类型

- level 基本图像等级

- internalformat 纹理中的颜色组件

- format 纹理数据格式,必须和internalformat 一样

- type 纹理数据的数据类型

- UNSIGNED_BYTE 无符号字节

- pixels 图像源

纹理对象还有一些相应参数需要设置一下

1 | gl.texParameteri( |

texParameteri(type, pname, param)

- type 纹理类型

TEXTURE_2D 二维纹理 - pname 纹理参数的名称

TEXTURE_MIN_FILTER 纹理缩小滤波器 - param 与pname相对应的纹理参数值

gl.LINEAR 线性

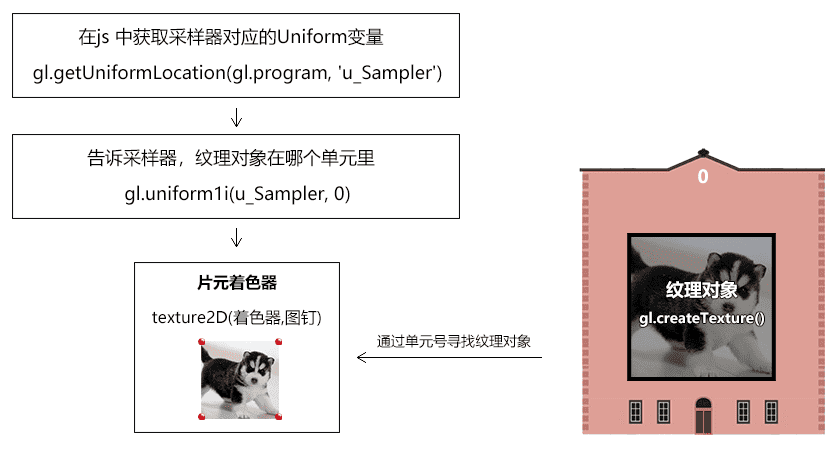

在js 中获取采样器对应的Uniform变量

告诉片元着色器中的采样器,纹理对象在哪个单元里。之后采样器便会根据单元号去单元对象中寻找纹理对象

1 | const u_Sampler = gl.getUniformLocation(gl.program, 'u_Sampler'); |

渲染

1 | render() |

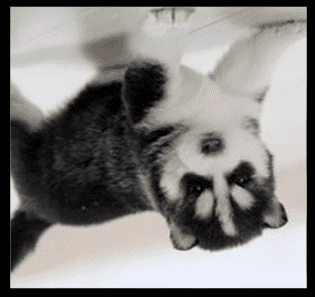

此时的效果如下,我们发现图片反了过来

这是由于Image对象遵守的是栅格坐标系,栅格坐标系的y轴朝下,而uv坐标系的y朝上,两者相反,所以画出的图形反了。

对图像进行预处理,将图像垂直翻转

1 | gl.pixelStorei(gl.UNPACK_FLIP_Y_WEBGL, 1); |

pixelStorei(pname, param) 图像预处理

pname 参数名

gl.UNPACK_FLIP_Y_WEBGL 是否垂直翻,布尔值,1|0

param 参数值

纹理容器

我们之前在贴图的时候,默认图像源的尺寸只能是2的n次方,比如2、4、8、16、……、256、512等。

如果我们把图像的尺寸改成非2次幂尺寸,如300*300,那贴图就无法显示。

我们要想解决这种问题,就得设置一下纹理的容器。

我们在图像上打图钉的时候,形成一块uv区域,这块区域可以理解为纹理容器。

纹理容器可以定义图钉区域的纹理如何显示在webgl图形中。

通过对纹理容器的设置,我们可以实现以下功能:

- 非二次幂图像源的显示

- 纹理的复制

- 纹理的镜像

非二次幂图像源的显示

1 | gl.texParameteri( |

TEXTURE_WRAP_S和TEXTURE_WRAP_T 就是纹理容器在s方向和t方向的尺寸,这里的s、t就是st坐标系里的s、t,st坐标系和uv坐标系是一回事。

CLAMP_TO_EDGE 翻译过来就是边缘夹紧的意思,可以理解为任意尺寸的图像源都可以被宽高为1的uv尺寸夹紧。

注:只有CLAMP_TO_EDGE 才能实现非二次幂图像源的显示,其它的参数都不可以。

纹理的复制

我们之前说过,uv坐标系的坐标基底分别是1个图片的宽和1个图片的高,可是如果我们将2个图片的宽高映射到了图形上会是什么结果呢?

我这里设置了maxV,和maxU就是会把2个图片的宽高映射到了图形上

1 | //数据源 |

如果我们不设置 gl.TEXTURE_WRAP_S,gl.TEXTURE_WRAP_T,那他的默认值就会是

1 | gl.texParameteri( |

效果就是如下

我们还可以对纹理进行镜像的复制

1 | gl.texParameteri( |

当然,我们也可以进行仅仅一边的复制

1 | gl.texParameteri( |

分子贴图

分子贴图mipmap 是一种纹理映射技术。

比如:

webgl中有一个正方形,它在canvas画布中显示的时候,占据了22个像素,我们要将一个88的图像源贴上去。

正方形中肯定不能显示图像源中的所有像素,因为它只有2*2=4个像素。

在Photoshop 中,会将图像源切割成2行、2列的色块,然后将每个色块的均值交个正方形。

在webgl 中也有类似的方法,并且它还有一层渲染性能的优化(Photoshop底层是否有这层优化我尚且不知)。

接下来咱们就说一下这层优化优化的是什么。

先想象一个场景,我要把10241024的图像源映射到canvas画布上22的正方形中,若把图像源分割求均值会产生庞大的数据运算,我们需要想办法把和正方形相映射的图像源的尺寸降到最小,比如就是2*2的。

因此,我们就需要分子贴图了。

分子贴图是一个基于分辨率等比排列的图像集合,集合中每一项的宽高与其前一项宽高的比值都是1/2。

如图所示:

在webgl 中,我们可以使用gl.generateMipmap() 方法为图像源创建分子贴图,

有了分子贴图后,之前2*2的正方形便会从分子集合中寻找与其分辨率最接近的分子图像。

在找到分子图像后,就需要基于webgl图形的片元尺寸对其分割取色了。

对于取色的方法,咱们之前说一个均值算法,其实还有其它算法。

我们看一下webgl 给提供的方法。

1 | //创建分子贴图 |

gl.texParameteri()方法中的第2个参数和第3个参数是键值对的关系。

TEXTURE_MAG_FILTER和TEXTURE_MIN_FILTER,对应的是纹理在webgl图形中的缩放情况。

- TEXTURE_MAG_FILTER 纹理放大滤波器,是纹理在webgl图形中被放大的情况。

- TEXTURE_MIN_FILTER 纹理缩小滤波器,是纹理在webgl图形中被缩小的情况。

TEXTURE_MAG_FILTER 具备以下参数:

- LINEAR (默认值) ,线性滤镜, 获取纹理坐标点附近4个像素的加权平均值,效果平滑

- NEAREST 最近滤镜, 获得最靠近纹理坐标点的像素 ,效果锐利

TEXTURE_MIN_FILTER 具备以下参数:

- LINEAR 线性滤镜,获取纹理坐标点附近4个像素的加权平均值,效果平滑

- NEAREST 最近滤镜, 获得最靠近纹理坐标点的像素,效果锐利

- NEAREST_MIPMAP_NEAREST Select the nearest mip level and perform nearest neighbor filtering .

- NEAREST_MIPMAP_LINEAR (默认值) Perform a linear interpolation between mip levels and perform nearest neighbor filtering within each .

- LINEAR_MIPMAP_NEAREST Select the nearest mip level and perform linear filtering within it .

- LINEAR_MIPMAP_LINEAR Perform a linear interpolation between mip levels and perform linear filtering : also called trilinear filtering .

注:后面这4个与分子贴图相关的参数适合比较大的贴图,若是比较小的贴图,使用LINEAR 或NEAREST 就好。

注:缩小滤波器的默认值取色方法是NEAREST_MIPMAP_LINEAR ,这个方法会从分子贴图里找分子图像,然后从其中取色,然而当我们没有使用gl.generateMipmap()方法建立分子贴图的时候,就得给它一个不需要从分子贴图中去色的方法,如LINEAR或NEAREST。

多纹理模型

比如我们要实现这样一个魔方,每个面的材质都不相同

有时候我们会很自然的想到一个面给它一个贴图,而实际上,最高效的方式是一个物体给它一个贴图,如下图:

这样我们只需要加载一次图片,建立一个纹理对象,做一次纹理和顶点数据的映射就可以了。

这里面没有涉及任何新的知识点,但这是一种很重要的项目开发经验。

整体代码如下:

1 | <script id="vertexShader" type="x-shader/x-vertex"> |

纹理模块化

这里修改一下我们的Poly

1 | const defAttr = () => ({ |

这里的map对象是这样的一个对象

1 | { |

- image 图形源

- format 数据类型,默认gl.RGB

- wrapS 对应纹理对象的TEXTURE_WRAP_S 属性

- wrapT 对应纹理对象的TEXTURE_WRAP_T 属性

- magFilter 对应纹理对象的TEXTURE_MAG_FILTER 属性

- minFilter对应纹理对象的TEXTURE_MIN_FILTER属性

然后添加一个更新贴图的方法

1 | updateMaps() { |

这样就可以在外部调用了

1 | const source = new Float32Array([ |

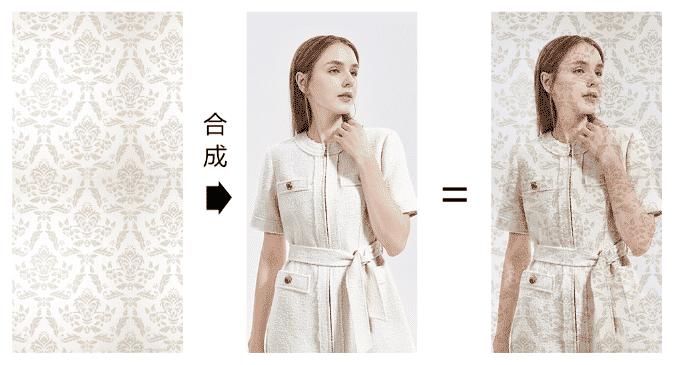

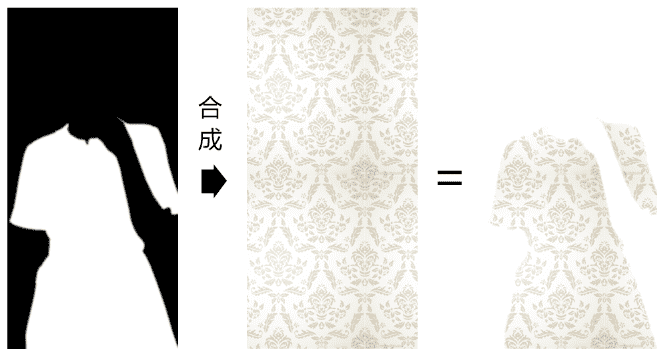

纹理合成

纹理合成就是按照某种规则将多张图片合在一起。

合成案例

比如这样:

或者:

又或者:

多图加载

纹理合成是需要多张图像源的,因此我们需要多张图像源都加载成功后,再去合成纹理。

我接下来就要使用Promise.all() 来实现这个逻辑。

1.将图像的加载方法封装进一个Promise 中,等图像加载成功后,再resolve。

1 | function imgPromise(img){ |

2.建立多个Image 对象

1 | const originImg = new Image() |

3.利用Promise.all 监听所有图片的记载成功

1 | Promise.all([ |

片元着色器合成纹理

1 | <script id="fragmentShader" type="x-shader/x-fragment"> |

u_Sampler 是原始图片采样器,对应下图:

u_Pattern 是纹理图案采样器,对应下图:

之后,我通过采样器找到原始图片和纹理图案的片元后,便可以对其进行运算;

1 | vec4 o=texture2D(u_Sampler,v_Pin); |

上面的po便是在对片元做分量相乘的运算,这种算法会让原始图片的亮度变暗,有点类似于ps里的正片叠底。

就是俩个向量相乘,因为在webgl中,因为片元分量的值域为[0,1],所以po 的亮度小于等于p和o

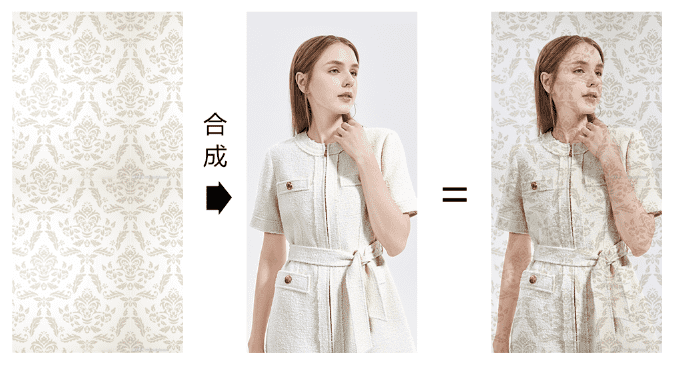

纹理混合

纹理混合就是按照一定比例,将第一张图像合到另一张图像上,这类似于ps 里的透明度合成。

我们直接看一下纹理在片元着色里的合成方法。

1 | <script id="fragmentShader" type="x-shader/x-fragment"> |

上面的mix() 方法便是按照比例对两个纹理的合成方法。

mix() 方法的返回数据类型会因其合成对象的不同而不同。

其规则如下:

1 | mix(m,n,a)=m+(n-m)*a |

举个例子:

已知:

m=3

n=5

a=0.5

求:mix(m,n,a)

1 | mix(m,n,a)=3+(5-3)*0.5 |

利用纹理合成完成转场动画

转场动画就是场景的淡入、淡出。

我们可以将一个纹理理解为一个场景,利用转场动画实现淡入、淡出效果。

在片元着色器中,将mix()方法中的比值设置为uniform 变量。

1 | <script id="fragmentShader" type="x-shader/x-fragment"> |

声明基础数据

1 | let n = 0 |

- n 当前显示的图片

- len 图片数量

- obj 混合比例的存储对象

- track 时间轨,我们在讲星空的时候讲过

建立矩形面

1 | const rect = new Poly({ |

加载图片

1 | loadImg() |

当图片加载完成后,会先更新图片,并连续渲染

1 | function changeImg(...imgs) { |

使用蒙版转场

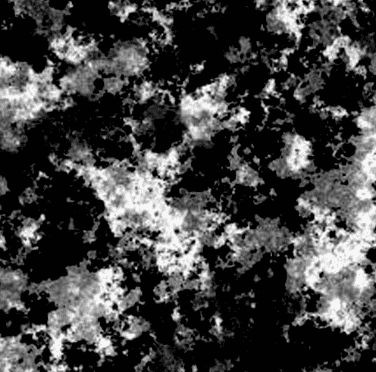

蒙版是一种为图像的提供合成数据辅助图像。

蒙版通常是黑白的,若是彩色,还需要将其转灰。

蒙版中的片元数据是一种插值,并不是一种具备特定功能的数据。

比如,我们可以将蒙版中的片元数据做为两张图像的亮度合成插值、饱和度合成插值、透明度合成插值等等。

大家通常会将蒙版和遮罩混为一谈,其实那也无可厚非,蒙版和遮罩的底层原理都是一样的。

只是,遮罩一般会被当成透明度合成的数据,它遵守黑透白不透的规律。

接下来,我就通过蒙版来实现纹理的花样转场。

1.建立一个蒙版图像,用作图案淡入的辅助数据

1 | loadImg() |

gradient 便是蒙版图像,效果如下:

2.在片元着色器里,使用蒙版合成图像。

1 | <script id="fragmentShader" type="x-shader/x-fragment"> |

我们重点看上面的浮点数 f。

g.r + u_Ratio 是让蒙版的亮度加上混合比值。

在灰度图像里,片元的r,g,b 数据都可以表示亮度。

clamp(n,min,max) 方法是用于限定数据极值的:

当n 小于min的时候返回min

当n 大于max的时候返回max

否则,返回n

clamp(-1,0,1) =0

clamp(2,0,1) =1

clamp(0.5,0,1) =0.5

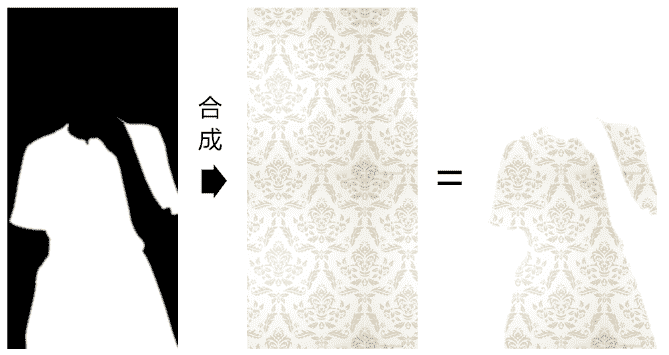

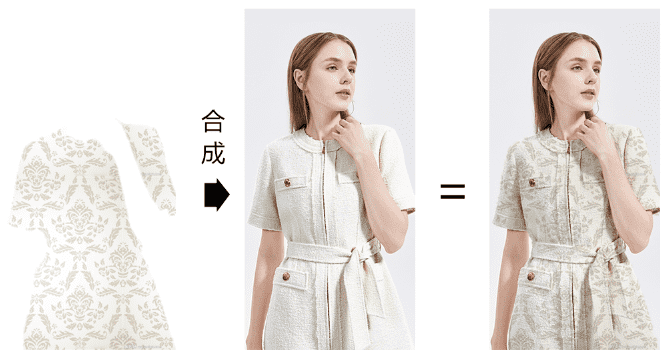

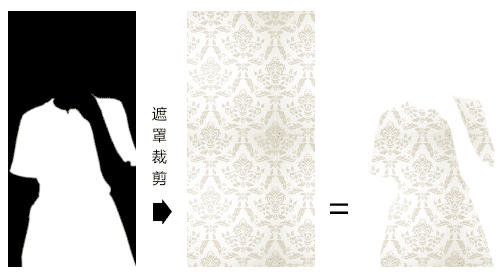

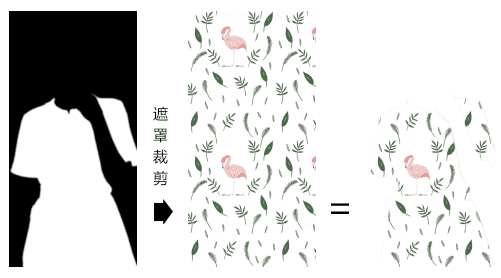

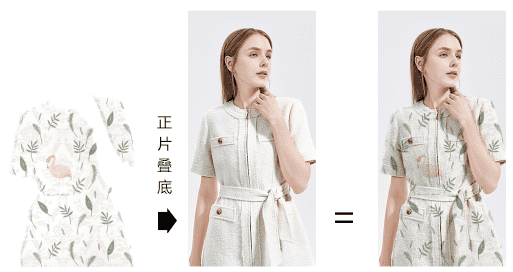

利用蒙版实现换装达人效果

我们先说一下换装达人的实现原理。

1.用一张黑白遮罩图对两个纹理图案进行裁剪,裁出裙子的区域。

2.对裙子区域的图案进行纹理混合

3.将纹理混合后的图案与原始图像进行正片叠底

接下来咱们再看一下代码实现。

1.建立矩形面

1 | const rect = new Poly({ |

2.建立原始图像和遮罩图像,在它们载成功后,将其写入到矩形面的贴图集合中,并再加载两个纹理图像。

1 | const originImg = new Image() |

3.加载纹理图案

1 | function loadImg() { |

4.将纹理图案写入到矩形面的贴图集合中,并建立轨道对象。

1 | function changeImg(...imgs) { |

5.连续渲染

1 | /* 动画 */ |

6.在片元着色器里进行纹理合成,

1 | <script id="fragmentShader" type="x-shader/x-fragment"> |

o 原始图像

p1 第1张纹理图案

p2 第二张纹理图案

m 蒙版图像

我通过m.x 来判断蒙版的黑白区域,m.y、m.z,或者m.r、m.g、m.b也可以。

p3片元默认为白色vec4(1,1,1,1)。

当m.x>0.5 时,p3为p1,p2的混合片元;

最终的gl_FragColor颜色便是p3和原始片元o的正片叠底。

视频纹理贴图

顾名思义,就是把原来图片换成视频就行了

- 正常建立纹理对象,并设置其相关属性。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18gl.activeTexture(gl.TEXTURE0)

const texture = gl.createTexture()

gl.bindTexture(gl.TEXTURE_2D, texture)

gl.texParameteri(

gl.TEXTURE_2D,

gl.TEXTURE_MIN_FILTER,

gl.LINEAR

)

gl.texParameteri(

gl.TEXTURE_2D,

gl.TEXTURE_WRAP_S,

gl.CLAMP_TO_EDGE

)

gl.texParameteri(

gl.TEXTURE_2D,

gl.TEXTURE_WRAP_T,

gl.CLAMP_TO_EDGE

) - 获取采样器对应的uniform 变量,并将纹理单元号赋给它。

1

2const u_Sampler = gl.getUniformLocation(gl.program, 'u_Sampler')

gl.uniform1i(u_Sampler, 0) - 建立video 对象,并播放

1

2

3

4

5

6

7

8

9

10const video = document.createElement('video');

video.src = 'http://img.yxyy.name/ripples.mp4';

video.autoplay = true;

video.muted = true;

video.loop = true;

video.setAttribute("crossOrigin", 'Anonymous');

video.play()

video.addEventListener('playing', () => {

ani()

}) - 在video 对象播放时,向纹理对象连续写入video

1

2

3

4

5

6

7

8

9

10

11

12

13function render() {

gl.texImage2D(

gl.TEXTURE_2D,

0,

gl.RGB,

gl.RGB,

gl.UNSIGNED_BYTE,

video

)

gl.clear(gl.COLOR_BUFFER_BIT);

gl.drawArrays(gl.TRIANGLE_STRIP, 0, sourceSize);

requestAnimationFrame(render)

}

结语

本篇文章就先到这里了,更多内容敬请期待,债见~